L2 Normalization là gì?

L2 Normalization là một công cụ toán học quan trọng trong xử lý dữ liệu, giúp tập trung vào hướng hoặc cấu trúc của dữ liệu thay vì quy mô của nó

L2 Normalization là một kỹ thuật toán học được sử dụng để chuẩn hóa các vector, biến chúng thành các vector đơn vị có độ dài bằng 1. Đây là một kỹ thuật cơ bản mà các kỹ sư phần mềm và chuyên gia học máy cần nắm vững để tối ưu hóa hiệu suất của các mô hình và ứng dụng.

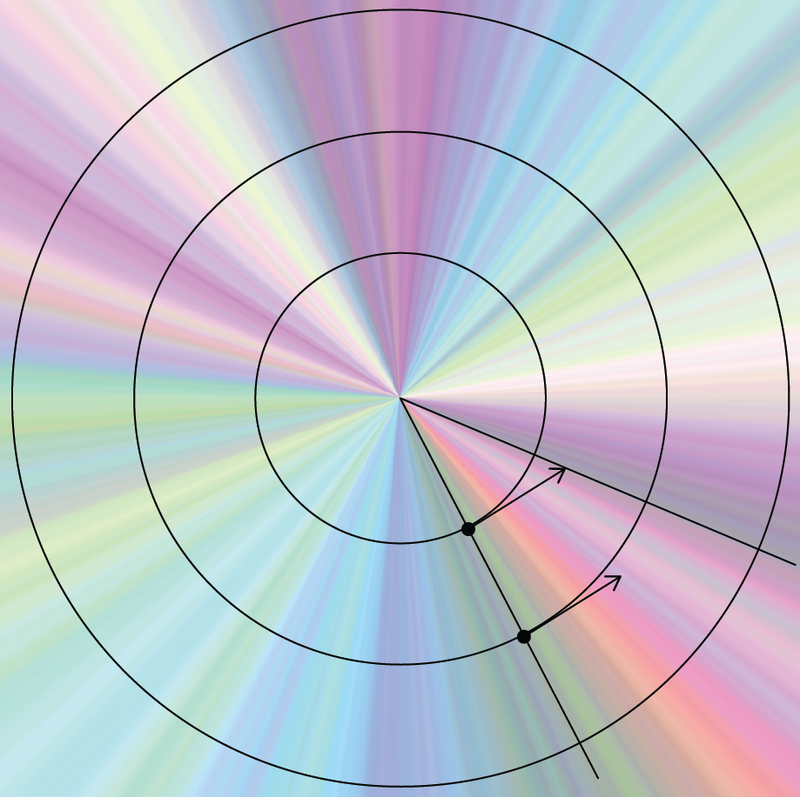

Để hiểu rõ hơn, hãy xem xét ví dụ sau:

Giả sử chúng ta có hai người, A và B, di chuyển trên một mặt phẳng tọa độ. Người A di chuyển theo hướng (3, 4) và người B di chuyển theo hướng (6, 8). Mặc dù B di chuyển xa hơn A, nhưng hướng di chuyển của họ là giống nhau.

L2 Normalization giúp chúng ta tập trung vào hướng di chuyển mà không bị ảnh hưởng bởi khoảng cách. Quá trình này bao gồm:

1. Tính độ dài của vector: Sử dụng định lý Pythagoras.

Độ dài vector A = √(3² + 4²) = 5

Độ dài vector B = √(6² + 8²) = 10

2. Chia mỗi thành phần của vector cho độ dài của nó:

A normalized = (3/5, 4/5) = (0.6, 0.8)

B normalized = (6/10, 8/10) = (0.6, 0.8)

Kết quả cho thấy sau khi chuẩn hóa, cả A và B đều có cùng vector (0.6, 0.8), phản ánh đúng thực tế là họ di chuyển cùng hướng.

Ứng dụng trong xử lý ngôn ngữ tự nhiên và học máy:

So sánh ngữ nghĩa: Giúp tập trung vào ý nghĩa của văn bản mà không bị ảnh hưởng bởi độ dài.

Cải thiện hiệu suất mô hình: Giúp các mô hình học máy hội tụ nhanh hơn trong quá trình huấn luyện.

Giảm thiểu vấn đề về tỷ lệ: Đảm bảo rằng các đặc trưng có tầm quan trọng tương đương trong quá trình học.

Lưu ý: Nhiều mô hình embedding hiện đại như OpenAI's 'text-embedding-3-large' hoặc Google Vertex AI's 'text-embedding-preview-0409' đã tích hợp sẵn L2 Normalization. Tuy nhiên, một số mô hình khác như BERT 'bert-base-uncased' không áp dụng chuẩn hóa trước, do đó các kỹ sư cần lưu ý điều này khi sử dụng.

L2 Normalization trong Thực Tiễn

Trong thế giới của học máy và xử lý dữ liệu, L2 Normalization không chỉ là một công thức toán học khô khan mà đã trở thành một công cụ thiết yếu để giải quyết những vấn đề phức tạp. Để hiểu rõ hơn về sức mạnh của kỹ thuật này, chúng ta cần đi sâu vào cả những ứng dụng thực tế lẫn các tối ưu hệ thống đi kèm.

Ứng Dụng Trong Xử Lý Ảnh và Nhận Diện Khuôn Mặt

Trong lĩnh vực thị giác máy tính, các vector đặc trưng thường có độ lớn thay đổi tùy thuộc vào điều kiện ánh sáng, góc chụp hoặc độ phân giải ảnh. L2 Normalization giúp chuẩn hóa các vector này, đảm bảo rằng khoảng cách giữa chúng phản ánh chính xác sự tương đồng về mặt ngữ nghĩa thay vì sự khác biệt do yếu tố kỹ thuật.

Ví dụ, trong hệ thống nhận diện khuôn mặt như FaceNet, mỗi khuôn mặt được biểu diễn bằng một vector embedding. Khi so sánh hai khuôn mặt, việc tính toán cosine similarity giữa các vector đã được chuẩn hóa L2 sẽ cho kết quả chính xác hơn nhiều so với việc sử dụng khoảng cách Euclid thông thường. Điều này đặc biệt quan trọng trong các ứng dụng bảo mật, nơi mà sai số nhỏ cũng có thể dẫn đến hậu quả lớn.

Tối Ưu Hóa Trong Hệ Thống Recommendation

Các hệ thống đề xuất sản phẩm dựa trên collaborative filtering thường làm việc với hàng triệu vector biểu diễn người dùng và sản phẩm. Khi các vector này không được chuẩn hóa, những sản phẩm có số lượng tương tác lớn (ví dụ: phim bom tấn) sẽ tự động chiếm ưu thế trong kết quả đề xuất, làm lu mờ các sản phẩm ít phổ biến nhưng có thể phù hợp với sở thích cá nhân.

Bằng cách áp dụng L2 Normalization, hệ thống có thể cân bằng giữa độ phổ biến và sự phù hợp cá nhân. Điều này không chỉ cải thiện trải nghiệm người dùng mà còn giúp doanh nghiệp khám phá ra những "viên ngọc ẩn" trong kho dữ liệu của mình.

Xử Lý Ngôn Ngữ Tự Nhiên: Từ Word Embeddings đến Semantic Search

Trong NLP, các mô hình embedding như Word2Vec hay GloVe tạo ra các vector có độ lớn khác nhau tùy thuộc vào tần suất xuất hiện của từ trong kho ngữ liệu. Một từ phổ biến như "the" có thể có vector với độ lớn đáng kể so với từ chuyên ngành ít gặp. Nếu không chuẩn hóa, điều này sẽ làm sai lệch đáng kể kết quả khi tính toán sự tương đồng giữa các từ hoặc câu.

Trong semantic search, việc chuẩn hóa L2 cho cả vector truy vấn (query) và vector tài liệu (document) giúp hệ thống tập trung vào ý nghĩa thực sự của văn bản thay vì độ dài hay tần suất từ khóa. Đây chính là chìa khóa để xây dựng những công cụ tìm kiếm thông minh có khả năng hiểu được ý định người dùng thay vì chỉ dựa vào từ khóa đơn thuần.

Những Điều Cần Lưu Ý Khi Triển Khai

Mặc dù L2 Normalization mang lại nhiều lợi ích, việc áp dụng nó một cách máy móc mà không hiểu rõ bối cảnh có thể dẫn đến những kết quả không mong muốn. Chẳng hạn, trong một số kiến trúc mạng neural hiện đại như Transformer, các lớp normalization (LayerNorm) đã được tích hợp sẵn để xử lý vấn đề này. Việc áp dụng thêm L2 Normalization có thể trở nên dư thừa hoặc thậm chí làm giảm hiệu suất mô hình.

Một điểm quan trọng khác là xử lý trường hợp vector có độ dài bằng không. Trong thực tế, dù hiếm gặp nhưng vẫn có những vector mà tổng bình phương các phần tử bằng không. Lúc này, phép chia để chuẩn hóa sẽ không xác định. Giải pháp phổ biến là thêm một giá trị epsilon rất nhỏ (ví dụ: 1e-8) vào mẫu số để đảm bảo tính ổn định số học.

Kết Luận

L2 Normalization là một trong những kỹ thuật căn bản nhưng vô cùng mạnh mẽ trong khoa học dữ liệu và học máy. Sự đơn giản trong công thức toán học của nó ẩn chứa một khả năng tinh tế trong việc cân bằng và chuẩn hóa dữ liệu, qua đó mở ra cánh cửa cho những giải pháp công nghệ tiên tiến. Hiểu rõ và áp dụng đúng kỹ thuật này không chỉ giúp cải thiện hiệu suất mô hình mà còn là bước đệm quan trọng để khám phá những khả năng mới trong lĩnh vực trí tuệ nhân tạo.

Trong tương lai, với sự phát triển của các kiến trúc mạng neural ngày càng phức tạp, vai trò của các kỹ thuật chuẩn hóa như L2 có thể sẽ tiếp tục được định nghĩa lại. Nhưng một điều chắc chắn rằng, nguyên tắc cốt lõi về việc đảm bảo tính nhất quán và cân bằng trong biểu diễn dữ liệu sẽ luôn là nền tảng của mọi hệ thống AI hiệu quả.

Comments